sitemap.xml是XML格式的网站地图,帮助搜索引擎高效发现并抓取页面,提升索引效率。它包含页面URL、修改时间、更新频率和优先级等信息,可扩展支持图片、视频等多媒体内容,是SEO优化的关键环节。

robots.txt是网站根目录下的纯文本文件,用于控制搜索引擎爬虫访问权限。核心指令包括User-agent、Disallow、Allow和Sitemap,可设置不同爬虫的抓取规则。常见场景有禁止全站访问、限制目录和文件类型等。需注意文件位置、路径大小写、非强制性等特点,建议结合站点地图和Meta标签实现精细控制。

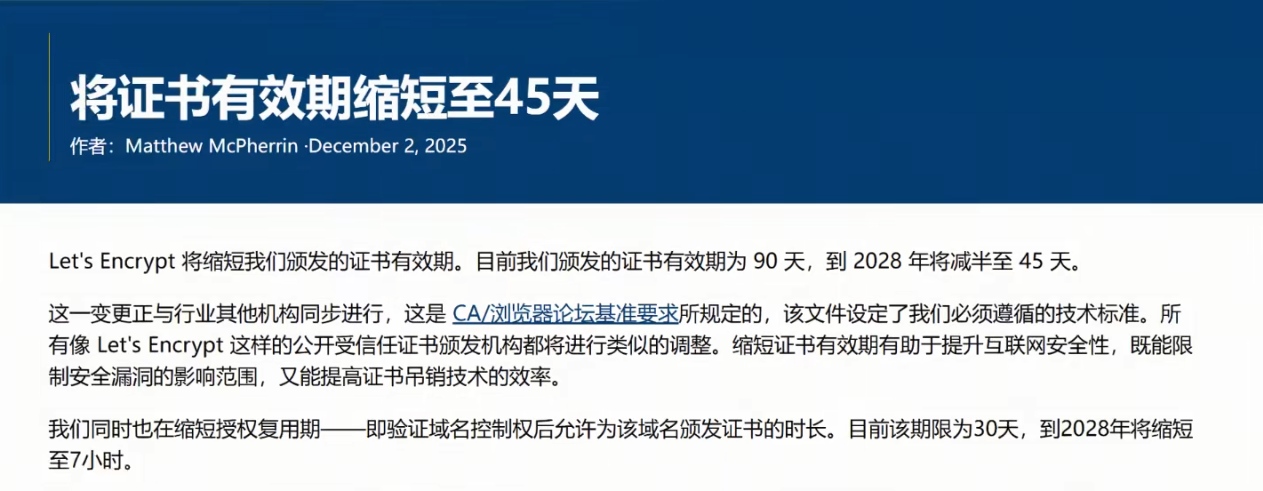

Let's Encrypt证书有效期将在2028年从90天缩短至45天,分阶段过渡至2028年2月完成。此调整与行业安全标准同步,旨在限制安全漏洞影响范围并提升证书吊销效率。用户有近3年时间准备,可通过调整ACME客户端配置灵活应对,无需紧急操作。

CSDN旗下GitCode平台未经许可擅自搬运GitHub上的开源项目,替换项目链接并创建开发者主页,严重侵犯开发者权益。此举引发开发者强烈抗议,大量用户要求删除自己的项目。CSDN为获取流量而采取的这种不道德行为不仅伤害了开发者,也污染了互联网环境,遭到开源社区广泛谴责。